Utilisation des Analytiques en Vidéo

Publié le 25 Oct 2024On en parle beaucoup. désormais. L’ IA (Intelligence Artificielle) ou le Deep Learning ( Apprentissage en profondeur) ou réalités augmentées sont présents partout, à la télé, dans les articles, sur Linkedin.

Mais en pratique que peut on faire réellement en terme de performances ? Acheter la bonne caméra ou le bon logiciel suffit -il ?

Toute utilisation d’analytiques doit répondre à une stratégie et des objectifs précis, sous peine de sombrer rapidement. Il faut également « mouiller la chemise » coté exploitant, et coté performances techniques car sans cela le projet sera difficile à porter à un haut degré d’efficacité et à conserver au travers de la maintenance.

- Définition d’un correspondant de l’exploitant chargé du suivi de l’efficacité du projet et de son amélioration, et qui fera l’interface avec les prestataires et fournisseurs de solutions,

- Définition d’objectifs limités et facilement mesurables statistiquement,

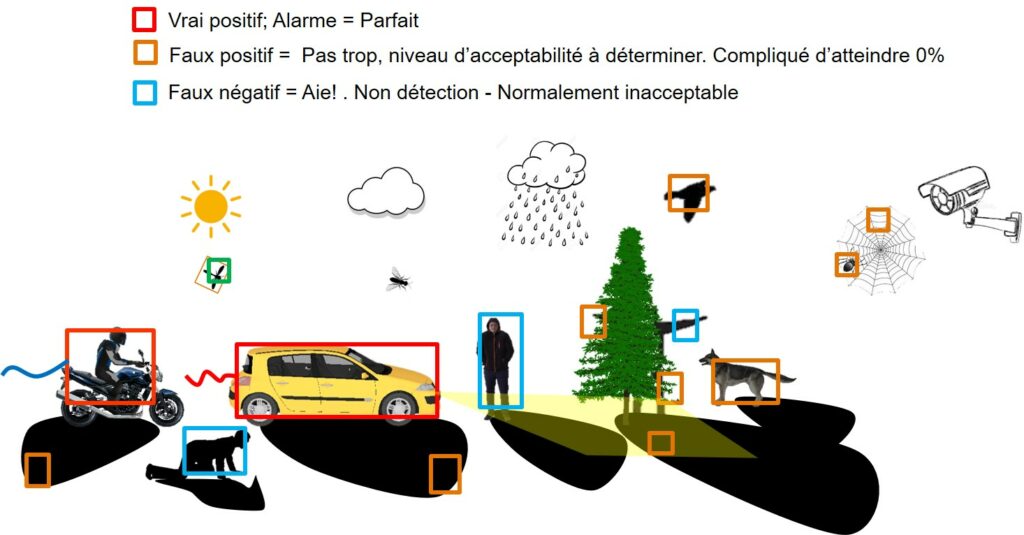

- Mise en place de protocoles de test périodiques avec suivi des faux positifs et stress test sur les possibles faux négatifs notamment en conditions climatiques dégradées (brouillard, neige, orage, canicule..ou mélange de tout cela )

- Suivi rigoureux des DOE et des réglages et sauvegardes afin de pouvoir reproduire ou améliorer des réglages, des asservissements, notamment lors des maintenances préventives ou curatives.

Actuellement la grande majorité des licences d’analyse en sureté se concentrent depuis des années sur la détection d’intrusion en périphérie de site avec des caméras thermiques. Plus efficaces en terme de faux positifs que les barrières infra rouge, les caméras thermiques couplées à des logiciels embarqués dans les caméras (edge analytique) ou dans des serveurs dédiés atteignent des taux de détection corrects pour peu qu’on tiennent compte des aléas de réchauffement pouvant atténuer les contrastes de températures.

Le détections « optiques » sont plus complexes car selon les éditeurs d’algorithmes, les résultats dépendront:

- de la luminosité (souvent la couleur permet plus de chose que le noir et blanc avec Infra rouge)

- du nombre de pixels sur la cible et du niveau de détails (ppm Largeur x Hauteur)

- de la netteté ( l’autofocus n’est pas forcement mon ami dans ce cas)

- de la qualité du flux analysé quand l’analyse est faite par un serveur ( Résolution, Ips, parfois le GOP, la compression …)

Ajoutons que les toiles d’araignées, les branches, les reflets et les ombres ne facilitent pas non plus la tâche des moteurs d’analyse. D’où l’idée de définir des zones « maitrisées » en luminosité, distance et ppm et bien maintenue avec des matériels qui ne génèreront pas trop d’intempestifs.